Per la prima volta un robot è riuscito a prevedere le azioni di un altro semplicemente osservando i suoi comportamenti: è la prova che anche le macchine possono provare empatia?

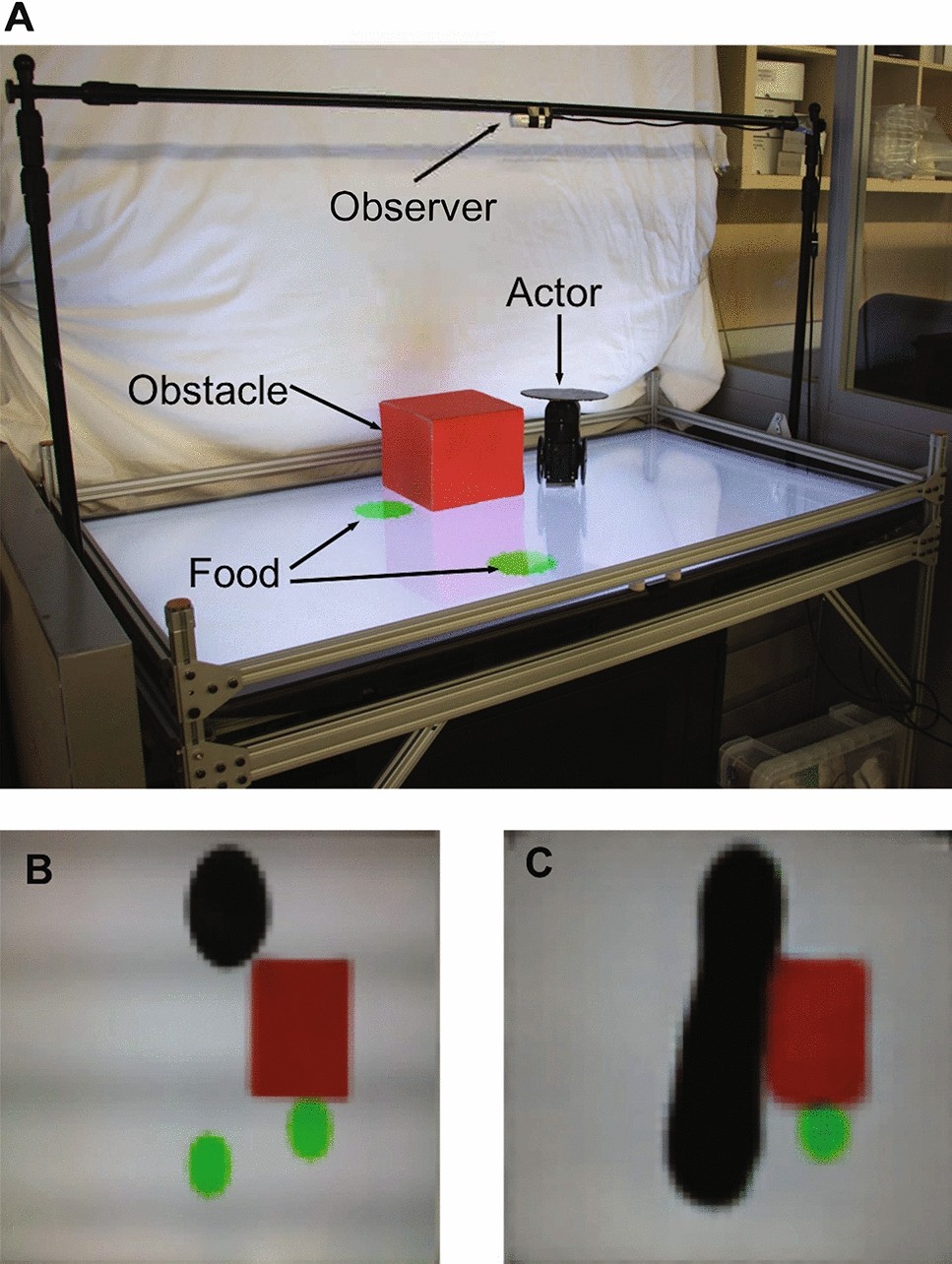

I robot possono provare empatia? Questa domanda – a metà strada tra fantascienza, robotica e intelligenza artificiale – tormenta da decenni gli scienziati e i sognatori di tutto il mondo. Oggi, però, forse è arrivata una prima (parziale) risposta. Un team di ingegneri della Columbia University di New York ha pubblicato un articolo sulla rivista Scientific Reports nel quale si dimostra – per la prima volta – che anche i robot possono “provare empatia”. Ossia prevedere le intenzioni di un altro soggetto semplicemente osservando le sue azioni. L’equipe guidata dall’ingegner Hod Lipson ha condotto un esperimento molto semplice con una coppia di robot dotati di intelligenza artificiale. Uno dei due robot (osservatore) si trova in alto e può “guardare” un tavolo.

Leggi anche → Costruire un braccio robotico a 16 anni: l’impresa di Thanos Tziatzioulis

I robot possono provare empatia?

La scienziata dell’Istituto Italiano di Tecnologia di Genova Cristina Becchio ha provato a spiegarci la portata della scoperta degli ingegneri della Columbia University di New York. “Semplicemente osservando i comportamenti dell’altro – ha dichiarato la scienziata – un robot molto semplice ma dotato di intelligenza artificiale è riuscito a prevederne i comportamenti. E’ quel che avviene durante molte delle interazioni umane, e fra le macchine si è verificato senza bisogno di fornire alcuna informazione. E’ bastata una telecamera montata sul primo robot e puntata sul secondo”. La “scoperta” è di per sé molto semplice ma potenzialmente rivoluzionaria. I comportamenti predittivi (vedo ciò che fai e agisco prevedendo ciò che farai un secondo dopo) sono alla base di tutte le relazioni sociali. L’esperimento degli ingegneri della Columbia University potrebbe dunque aprire le porte ad una nuova era dell’Intelligenza Artificiale. In un’era in cui i robot saranno capaci di interagire con gli uomini o con altri robot senza bisogno di istruzioni, grazie soltanto alla loro capacità di “osservare” e “prevedere” i comportamenti. Oggi – spiega Becchio – i robot dotati di intelligenza artificiale “svolgono compiti assai più complessi di quelli descritti nell’esperimento della Columbia University. Ma hanno la caratteristica di reagire al comportamento altrui, non di prevederlo. In questo modo le interazioni perdono fluidità. Se ogni volta bisogna attendere la reazione della macchina, i tempi si allungano. Tutte le interazioni sociali hanno invece natura predittiva”. Ed è proprio qui che si compie la rivoluzione. “L’esperimento di oggi dimostra che osservare può essere sufficiente per prevedere i comportamenti altrui. Una volta che so rappresentarmi uno stato mentale altrui, posso agire in modo empatico o manipolarlo in modo machiavellico. Oggi un’intelligenza artificiale riesce a prendere l’immagine di una persona che si trova per strada con il piede alzato e a fargli completare il passo. Un robot capace di prevedere i comportamenti, saprà anche ricostruirne il percorso futuro“.

Potrebbe interessarti anche → Nuova pelle elettronica che riproduce il tatto